Un début de siècle agité

Comme je le soulignais au début de l’article précédent, les guerres agissent comme un catalyseur de progrès techniques. Ce constat s’est particulièrement vérifié lors du XXème siècle, caractérisé par de multiples et profonds chamboulements dans les structures humaines, politiques, sociaux ou même scientifiques. Mais les plus puissants vecteurs d’avancées technologiques sont militaires, et commencent dès 1914 avec la Première Guerre Mondiale. Celle-ci va conditionner les nouvelles guerres modernes avec l’apparition de nouveaux moyens de transport (avions, voitures, dirigeables) ou leur amélioration (bateaux, trains, sous-marins, chars de guerre) ; des systèmes d’armement plus performants, l’usage de gaz létaux ou la conversion d’usines pour l’effort de guerre ; enfin, la médecine avec des avancées en hygiène, en chirurgie ou la découverte des groupes sanguins.

De l’utilité des machines à calculer pour faire la guerre

Le numérique et les calculateurs sont plutôt absents de cette tragédie. Ils joueront un rôle majeur au cœur de la prochaine guerre, qui aura lieu 25 ans plus tard. Un des premiers protagonistes est un ingénieur allemand, Konrad Zuse, qui construit ses calculateurs mécaniques, les Z1 et Z2, entre 1935 et 1939. Cependant, ces deux modèles ne sont pas totalement fonctionnels. Zuse travaille alors sur de nouvelles machines plus abouties, les Z3 et Z4, qui seront présentées à l’Institut allemand de recherches aéronautiques, mais ne seront que faiblement utilisées par le régime nazi. Fait remarquable, Zuse utilise une architecture similaire à celle de Charles Babbage, sans pour autant qu’il n’ait eu connaissance de ses travaux [1].

Au contraire des machines de Zuse qui seront peu utilisées, les autres camps vont recourir à des calculateurs afin de les aider dans différents domaines. Ces domaines vont converger et former un large socle de ce qui deviendra de nos jours, l’informatique et le numérique.

Au contraire des machines de Zuse qui seront peu utilisées, les autres camps vont recourir à des calculateurs afin de les aider dans différents domaines. Ces domaines vont converger et former un large socle de ce qui deviendra de nos jours, l’informatique et le numérique.

La protection des données : un vieux combat

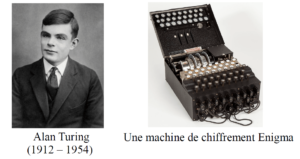

Le premier domaine concerne le chiffrement des données. Les allemands utilisent pour communiquer un système de cryptage très perfectionné. Il dépend d’une machine capable de chiffrer un message, la célèbre machine Enigma. Les services secrets anglais vont travailler à obtenir des renseignements sur cette machine, voire même en obtenir une. En parallèle, ils rassemblent des experts chargés de casser le code. Nous rencontrons notre second protagoniste, le mathématicien et cryptologue britannique Alan Turing. Son travail sera capital dans le processus de déchiffrement [2]. Il proposera des méthodes statistiques qui réduisent les temps d’analyse, et contribue à l’amélioration de la « bombe » polonaise, instrument électromécanique qui permettra de casser le chiffrement Enigma. Outre son rôle dans le chiffrement, il publiera sur la morphogenèse, mais sera mieux connu pour deux contributions majeures : dans le domaine de l’informatique avec la Machine de Turing [3] (voir Note 1), et dans l’intelligence artificielle avec le Test de Turing [4] (voir Note 2).

Systèmes auto-régulés et contrôle

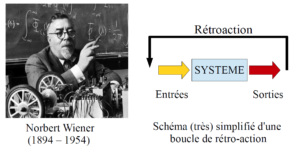

Le second domaine est la cybernétique, connu et popularisé seulement après guerre dû au nécessaire maintien du secret militaire autour de celui-ci. La cybernétique fut fondée en 1948 par Norbert Wiener, mathématicien américain, et s’articule autour de la notion de rétro-contrôle (ou feedback, voir Note 3). Le rétro-contrôle désigne le fait d’utiliser les résultats d’une action pour moduler ce qui a amené à cette action, comme un tireur corrigeant la trajectoire de son tir. Wiener développa ce champ d’application après avoir travaillé à améliorer la précision de visée des systèmes anti-aérien, durant la Seconde Guerre Mondiale [5]. L’étymologie du terme cybernétique vient du grec κυβερνητική (kubernêtikê, gouverner, diriger) [6], étymologie qui se retrouve dans les mots gouvernail, gouvernement. C’est d’ailleurs dans à cet usage qu’il est employé par André-Marie Ampère en 1834 ; Wiener choisit le terme pour définir le champ du contrôle et de la théorie de la communication [6]. Bien qu’elle ne soit pas directement liée à l’essor du numérique, ou même des premiers ordinateurs, la cybernétique intervient maintenant dans de nombreux domaines du numérique comme par exemple la robotique, l’intelligence artificielle ou les systèmes automatisés ; ou dans d’autres domaines comme la biologie ou l’écologie.

Nous avons automatisé le travail, nous automatiserons le calcul

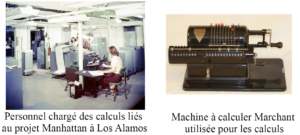

Un troisième domaine concerne le programme de développement de l’arme nucléaire des U.S.A., au sein du projet Manhattan. Il regroupe de nombreux chercheurs de différents champs d’expertise qui sont chargés de travailler sur la construction d’une arme nucléaire. Le nombre considérable de calculs nécessaire à analyser différents aspects dans la construction de la bombe obligea à déléguer ces calculs. Des personnes furent choisies pour les effectuer, la plupart étant des femmes, comme les épouses des chercheurs travaillant sur place. Agissant comme des « ordinateurs humains », cette escouade regroupait les pages de calculs produites par les chercheurs, et procédait à leur résolution en utilisant des machines à calculer de bureau Merchant. L’intérêt de cette démarche est multiple : la plupart des « ordinateurs humains » était qualifiée en mathématiques ou en physique ; cela limite le gâchis de ressources humaines en demandant à tout le personnel de s’impliquer dans le projet ; et cela réduit la demande de civils extérieurs au projet, et dont le secret doit être maintenu à son maximum. Cependant, à la fin de l’année 1943, des machines à calculer de la firme I.B.M sont introduites. Elles reçoivent leurs données par cartes perforées, et peuvent réaliser des calculs sur des temps plus longs, là où les êtres humains tendent à fatiguer. Les gros calculs concernant l’hydrodynamique de l’implosion, et des explosions sont réalisés sur ces calculateurs [7] [8].

Des calculateurs à l’ordinateur

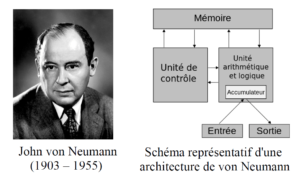

La transition entre machine à calculer et les premiers ordinateurs a eu lieu durant les années 1940. Les britanniques ont construit et utilisé une dizaine de machines nommées Colossus pour casser le code Lorenz, utilisé par les hauts gradés allemands [9]. Dans le même temps, les américains travaillent sur l’ENIAC (Electronic Numerical Integrator and Computer), une imposante machine électronique, proche du Colossus, qui sera utilisée pour le calcul balistique à partir de 1945. La nécessité de disposer de machines plus puissantes pousse les autorités à promouvoir de telles initiatives. John von Neumann, physicien et mathématicien américano-hongrois, va grandement contribuer à l’avancée de l’informatique, ainsi que plusieurs autres domaines comme la physique quantique, la théorie des jeux ou les sciences économiques. Il rassemble John Presper Eckert et John William Mauchly, les pères de l’ENIAC, ainsi que d’autres scientifiques afin de construire une machine plus performante, l’EDVAC (Electronic Discrete Variable Automatic Computer). Ils formalisent dans un rapport publié en 1945 une structure plus efficace pour les systèmes informatiques, connue aujourd’hui sous le nom d’ « architecture de von Neumann », et qui constitue l’architecture de tous nos ordinateurs modernes [8].

Le numérique moderne naît avec la mise au point de ces premiers ordinateurs électroniques. Puisque les signaux numériques sont constitués de nombres discrets et finis, il devient possible de ne traiter que ces nombres, en place d’un signal analogique plus complet mais également plus lourd. L’électronique utilisant un mode de transmission binaire convient parfaitement pour transmettre les nombres du numérique, en faisant un support de choix. Par conséquent, le développement du matériel électronique va de pair avec celui de ce que l’on appelle « la révolution numérique », que nous aborderons lors des prochains articles.

Sources

[1] Vicenç Torra, Del ábaco a la revolución digital: algoritmos y computación, 2010

[2] L’excellente page Wikipédia anglaise concernant Alan Turing : https://en.wikipedia.org/wiki/Alan_Turing

Note 1: La Machine de Turing est un modèle abstrait de computation algorithmique, dans lequel une machine lit des instructions situées sur un ruban. Elle se déplace et réalise l’action mémorisée, puis lit une nouvelle instruction, la procédure se répète ensuite, théoriquement à l’infini. Elle est décrite dans l’article publié en 1936, référence [3] ci-dessus.

[4] Turing, A. M., (1950) ; Computing machinery and intelligence, Mind

Note 2: Le Test de Turing est une proposition faite par Turing pour répondre à la question « Est-ce qu’une machine peut penser ?« . Le but du test est de discriminer entre un être humain et une machine, qui tiendront une conversation. Si l’humain peut déterminer qu’il parle à une machine, alors le test est négatif. Ce test est une variante du ‘Imitation game« , jeu dans lequel deux personnes sont dans une pièce, tandis qu’une troisième personne doit déterminer le sexe de chacun, en leur posant des questions. Parmi ces deux personnes, un homme et une femme. Un doit induire l’interrogateur en erreur, alors que le second doit l’aider dans sa tâche. Proposition faite dans l’article publié en 1950, référence [4] ci-dessus.

Note 3: Ce phénomène est très courant dans le vivant comme la régulation de la pression sanguine ou le circuit dopaminergique de la récompense, qui fonctionne très bien avec les aliments sucrés (cf. réflexe de Pavlov et conditionnement classique). L’apprentissage animal s’appuie sur ce phénomène, où des stimuli vont renforcer des connexions neuronales, et favoriser l’acquisition d’une information, d’un comportement. Le deep learning est une application de ce principe sur des neurones informatiques pour enseigner aux machines, comme en intelligence artificielle.

[5] Conway, Flo ; Siegelman, Jim (2005). Dark Hero of the Information Age: in search of Norbert Wiener, the father of cybernetics. New York: Basic Books

[6] http://www.cnrtl.fr/definition/cybern%C3%A9tique

[7] https://www.atomicheritage.org/history/human-computers-los-alamos

[8] https://www.atomicheritage.org/history/computing-and-manhattan-project

[9] https://en.wikipedia.org/wiki/Colossus_computer

Et de manière générale, pour toutes les parties, l’excellent livre de Vicenç Torra sur l’histoire et l’évolution des chiffres, des algorithmes et des machines à calculer ; voir référence [1]

Tous crédits images : wikipédia.org, sauf :

Norbert Wiener (http://www.ieeevic.org/video-interview-norbert-wiener-inventor-of-cybernetics/)

Les images « ordinateurs humains » et machine à calculer Marchant, voir référence [8]