Le numérique : Depuis quand ?

La notion de numérique existe depuis plus longtemps que l’on peut le croire. Si le développement de l’Internet dans les années 1990 semble marquer ses débuts, il conviendrait plutôt de placer cette « naissance » dans les années 1930-1940. Comme souvent, les temps de guerre sont propices aux avancées scientifiques, et cette période fut fertile dans de nombreux champs comme la cryptographie, la fission nucléaire ou encore les systèmes cybernétiques (nous nous pencherons plus en détails sur ces avancées par la suite). Nombre de projets de cette période ont en commun le numérique, qui repose sur le calcul, l’acte de computer (du latin computare, calculer, compter)[1]. Ce lien fort entre numérique et calcul nous enjoint donc à regarder plus loin dans le passé pour chercher les racines de ces termes.

Les premiers usages : des machines pour calculer

Les premières utilisations humaines datent probablement des premiers comptages effectués sur leurs doigts par nos lointains ancêtres. D’ailleurs, en anglais, numérique se dit digital (du latin digitus, doigt), qui donnera digit en anglais (chiffre) et doigt en français[2]. Ce qui, au passage, engendre quelques débats sur la bonne utilisation linguistique et sémantique.

Si les hommes utilisaient déjà des moyens rudimentaires pour compter, notamment avec des bouts d’os ou des marques sur des bâtons, la première machine permettant de calculer est pleinement numérique et associe à chaque unité de comptage un objet qui peut être déplacé sur un rail ; c’est le boulier. C’est également la naissance du calcul (du latin calculus, petit caillou)[3], forme avancée de comptage qui permet d’associer et de manipuler des chiffres[4].

Il faudra attendre le XVIIème siècle pour voir apparaître des modifications drastiques sur cette machine à calculer. Blaise Pascal réalise la première vraie machine à calculer moderne, la pascaline[5]. Celle-ci est numérique et mécanique, fonctionne avec des engrenages, et permet de réaliser additions et soustractions avec gestion des retenues.

Le binaire pour compter, le binaire pour tisser

Gottfried Leibniz travaillera lui aussi sur une machine à calculer, et se penchera sur une autre façon de compter. Dans des mémoires de 1703, il décrit l’utilisation d’une méthode arithmétique en binaire, et définit le couple 0/1 comme caractères de comptage[6].

Au milieu du XVIIIème siècle, l’usage du binaire trouve une place dans la manufacture de la soie à Lyon. En 1725, Basile Bouchon crée la première machine à tisser semi-automatique en utilisant des cartes perforées. Celles-ci contiennent la séquence de travail à effectuer sous forme binaire, la présence de trous perforés dans la carte équivaut à un programme binaire 0/1 (troué/non troué). Ce procédé sera modifié et perfectionné par son assistant Jean Baptiste Falcon (1728) puis par Jacques Vaucanson (1740). La version la plus aboutie sera commercialisée par Joseph Jacquard, en 1805, et sera l’objet d’intérêt de l’empereur Napoléon Bonaparte[7].

L’ancêtre de nos ordinateurs

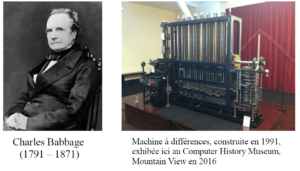

Durant la première partie du XIXème siècle, le mathématicien et inventeur Charles Babbage va concevoir et entreprendre de construire une machine à calculer mécanique. La construction d’une première machine commence en 1822, la machine à différences (the Difference Engine), bénéficiant d’un financement par le gouvernement britannique. Les coûts pour le prototype deviennent trop importants, et le projet se termine dans les années 1830. Babbage travaille alors à la conception d’une nouvelle machine, plus proche encore de nos ordinateurs contemporains, la machine analytique (the Analytical Engine). Il intègre deux nouveautés : un apport en énergie avec un moteur à charbon, ainsi qu’une entrée qui reçoit des cartes perforées, et peut théoriquement en imprimer en sortie. Théoriquement car la construction de cette machine n’aura pas lieu, également faute de financements, devant les coûts colossaux de la machine et face à sa faible utilité pratique.

Les débuts de la programmation

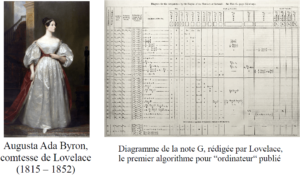

Lors de cette aventure, Babbage fait la rencontre d’une mathématicienne Ada Lovelace, fille du Lord Byron. Cette dernière est considérée de nos jours comme la première « programmeuse », et a fortement contribué aux travaux de Babbage. Ce dernier demanda à Lovelace de lui traduire un texte écrit en français, et concernant sa machine. Lovelace réalisa la tâche tout en ajoutant de nombreuses notes, qui vont enrichir le texte original. Notamment, l’écriture de la note G, qui décrit un algorithme pour calculer les nombres de Bernoulli, réalisant ainsi le premier programme informatique de l’Histoire. La collaboration entre Babbage et Lovelace fut si étroite, qu’il est parfois difficile de distinguer à quel point les idées de cette dernière ont pu influencer les travaux de Babbage. Les travaux d’Ada Lovelace tomberont dans un oubli relatif, avant d’être republiés dans les années 1950. Le langage de programmation « Ada » lui est dédié[8].

Le binaire pour décider, le binaire pour calculer

Le binaire sera au centre du travail de Georges Boole, dans son étude de l’analyse mathématique de la logique (1847). Ce travail sera fondamental pour la logique, mais également pour l’électronique, l’algorithmique ou l’informatique avec la découverte des fonctions logiques ou encore des booléens[9].

A la fin du XIXème siècle, le principe du métier à tisser Jacquard et son système de cartes perforées est modifié pour le recensement de la population des États-Unis. Celui a lieu tous les dix ans, mais son traitement manuel dure presque autant (celui de 1880 dure 9 ans). Le bureau de recensement lance un concours pour moderniser son outil de travail. Herman Hollerith construit une machine statistique semi-automatique sur le principe de cartes perforées. Sa machine sera alors utilisée pour le prochain recensement de 1890. En 1911, Hollerith revend cette entreprise, qui sera regroupée avec 3 autres entités au sein de la Computing Tabulating Recording Company, renommée en 1924 International Business Machine Company, plus connue sous le nom du géant de l’informatique, I.B.M[10].

Sources

[1] http://www.cnrtl.fr/etymologie/computer

[2] http://www.academie-francaise.fr/digital

[3] http://www.cnrtl.fr/etymologie/calculer

[4] Georges Ifrah, Histoire universelle des chiffres, Seghers, 1981

[5] Blaise Pascal, Lettres dédicatoires à Monsieur le Chancelier, 1645

[6] Liebniz, G.G. ; Explication de l’arithmétique binaire, qui se sert des seuls caractères O et I avec des remarques sur son utilité et sur ce qu’elle donne le sens des anciennes figures chinoises de Fohy, 1703 (version numérisée : HAL Id: ads-00104781)

[7] Documentation musées Gadagne, disponible à l’adresse : www.gadagne.musees.lyon.fr

[8] Vicenç Torra, Del ábaco a la revolución digital: algoritmos y computación, 2010

[9] Boole, G. (1847) ; The mathematical analysis of logic, réédité par Philosophical Library en 1948

[10] Biographie d’Hermann Hollerith (en anglais), disponible à l’adresse : https://www.immigrantentrepreneurship.org/entry.php?rec=286

Tous crédits images : wikipédia.org, sauf :

Usage du binaire en arithmétique, voir référence [6]